AI 개발 실무자를 위한 파이썬 도구 및 프레임워크 마스터 가이드: 2025년 최신 트렌드 반영

이 가이드는 AI 개발 실무자를 위한 2025년 최신 파이썬 도구 및 프레임워크 활용법을 제시합니다. 파이썬 딥러닝 프레임워크 비교를 통해 최적의 선택을 돕고, Python FastAPI 활용법으로 AI 모델을 효율적으로 서비스하는 방법을 상세히 설명합니다. 또한, 실제 AI 데이터 분석 사례를 통해 실무 워크플로우를 익히고, MLOps, 클라우드 플랫폼, 2025년 AI 트렌드 및 학습 로드맵까지 총체적인 실전 역량 강화를 위한 핵심 지식을 제공합니다. 이 가이드를 통해 AI 개발 여정의 다음 단계를 준비하세요.

목차

AI 기술은 우리 삶의 모든 부분을 빠르게 변화시키고 있습니다. 이러한 변화의 중심에는 바로 파이썬 딥러닝 프레임워크가 있습니다. AI 개발 실무자나 이 분야에 새롭게 뛰어들려는 분들에게 파이썬은 선택이 아닌 필수가 되었죠. 2025년 현재에도 파이썬은 AI 분야에서 독보적인 1위 언어 자리를 굳건히 지키고 있습니다. 이는 파이썬이 가진 간결한 문법과 믿을 수 없을 만큼 방대한 생태계 덕분입니다.

최근 인공지능 개발 트렌드를 살펴보면, 대규모 언어 모델(LLM)이나 멀티모달 기술 같은 ‘생성형 AI’가 큰 주목을 받고 있습니다. 또한, 스마트폰이나 작은 기기에서도 AI가 작동하는 ‘엣지 AI’와, AI 모델을 만들고 관리하며 배포하는 과정을 자동화하는 ‘MLOps’ 및 ‘AI 플랫폼 고도화’ 역시 중요해지고 있습니다. 이러한 첨단 트렌드 속에서 파이썬 생태계는 핵심적인 역할을 합니다. 강력한 딥러닝 프레임워크부터 AI 모델을 웹 서비스로 만드는 도구, 그리고 MLOps를 위한 다양한 라이브러리까지 파이썬은 인공지능 기술의 모든 단계를 아우르며 혁신을 이끌고 있습니다.

이 글에서는 AI 개발자들이 2025년 실제 프로젝트에서 바로 쓸 수 있는 핵심 지식과 실질적인 솔루션을 제공합니다. 주요 파이썬 딥러닝 프레임워크를 꼼꼼하게 비교하고, 어떻게 하면 Python FastAPI 활용법을 통해 AI 모델을 빠르고 안정적으로 서비스할 수 있는지 알려드릴 것입니다. 더 나아가, 실제 AI 데이터 분석 사례들을 통해 프로젝트의 처음부터 끝까지 워크플로우를 익힐 수 있도록 도와드립니다. 이 가이드를 통해 여러분은 AI 개발 실무에 필요한 핵심 역량을 단단히 다질 수 있을 것입니다.

2. 파이썬 딥러닝 프레임워크 완전 가이드

인공지능 개발의 핵심은 데이터를 학습하여 예측하거나 새로운 것을 만들어내는 모델을 만드는 것입니다. 이때 우리를 돕는 도구가 바로 파이썬 딥러닝 프레임워크입니다. 이 섹션에서는 현재 가장 많이 쓰이는 주요 프레임워크들을 하나씩 살펴보고, 어떤 상황에서 어떤 프레임워크를 선택해야 하는지에 대한 실질적인 조언을 드릴 것입니다.

2-1. 주요 프레임워크 개별 소개

PyTorch

2024년과 2025년 현재, 연구, 논문, 그리고 다양한 오픈소스 프로젝트에서 가장 널리 사용되는 파이썬 딥러닝 프레임워크는 단연 PyTorch입니다. PyTorch의 가장 큰 특징은 ‘동적 계산 그래프(Dynamic Computation Graph)’를 사용한다는 점입니다. 이는 마치 코드를 작성하면서 바로 그래프를 만들고 실행하는 것과 같아서, 코드가 직관적이고 디버깅(오류 찾기)이 매우 쉽습니다. 파이썬 문법과 비슷하게 설계되어 있어 학습 곡선이 낮고, 빠르게 아이디어를 실험해 볼 수 있는 ‘빠른 프로토타이핑’에 아주 강합니다. 덕분에 자연어 처리(NLP)나 컴퓨터 비전(CV) 분야의 복잡한 커스텀 모델(맞춤형 모델)을 구현할 때 특히 유용합니다. Hugging Face Transformers, torchvision, torchaudio와 같은 강력한 라이브러리 생태계를 갖추고 있어 활용 범위가 매우 넓습니다.

TensorFlow / Keras

Google이 주도하는 파이썬 딥러닝 프레임워크인 TensorFlow는 대규모 분산 학습, Google의 특수 칩인 TPU(Tensor Processing Unit) 활용, 그리고 모바일/엣지 디바이스(스마트폰이나 작은 기기) 배포를 위한 TFLite, AI 모델을 안정적으로 서비스할 수 있는 TensorFlow Serving 등 ‘프로덕션 환경’에 최적화된 강력한 도구들을 제공합니다. 특히 Keras는 TensorFlow 위에 구축된 고수준 API로, 몇 줄의 코드만으로도 딥러닝 모델을 빠르게 만들 수 있어 프로토타이핑에 매우 효과적입니다. 동시에 TensorFlow의 저수준 API를 활용하면 모델의 세밀한 부분까지 제어할 수 있어, 개발자가 원하는 대로 모델을 커스터마이징할 수 있습니다. 이는 대규모 서비스나 모바일 AI 앱 개발에 TensorFlow가 강력한 선택지가 되는 이유입니다.

JAX

Google이 개발한 JAX는 고성능 수치 계산 라이브러리로, 파이썬의 NumPy와 매우 유사한 문법을 제공합니다. 이 프레임워크의 핵심은 ‘자동 미분(Automatic Differentiation)’ 기능과 ‘XLA(Accelerated Linear Algebra) 컴파일러’입니다. 자동 미분은 딥러닝 모델 학습에 필수적인 기울기(gradient) 계산을 자동으로 해주고, XLA 컴파일러는 GPU나 TPU 같은 하드웨어 가속을 최대한 활용하여 연산 속도를 극대화합니다. 연구자들 사이에서 빠르게 성장하고 있으며, 함수형 프로그래밍 스타일을 지향하는 것이 특징입니다. 다만, PyTorch나 TensorFlow에 비해 아직 생태계와 활용할 수 있는 도구들이 상대적으로 작다는 단점이 있습니다. 최첨단 연구나 매우 높은 성능이 요구되는 분야에서 그 진가를 발휘합니다.

이 외에도 PyTorch Lightning과 fast.ai와 같은 프레임워크들은 PyTorch 위에 구축되어 코드를 더 간결하게 만들고 개발 효율성을 높여주는 추상화된 기능을 제공합니다. 이들은 복잡한 딥러닝 코드를 표준화하여 빠르게 실험하고 배포할 수 있도록 돕습니다.

2-2. 프레임워크 선택 가이드

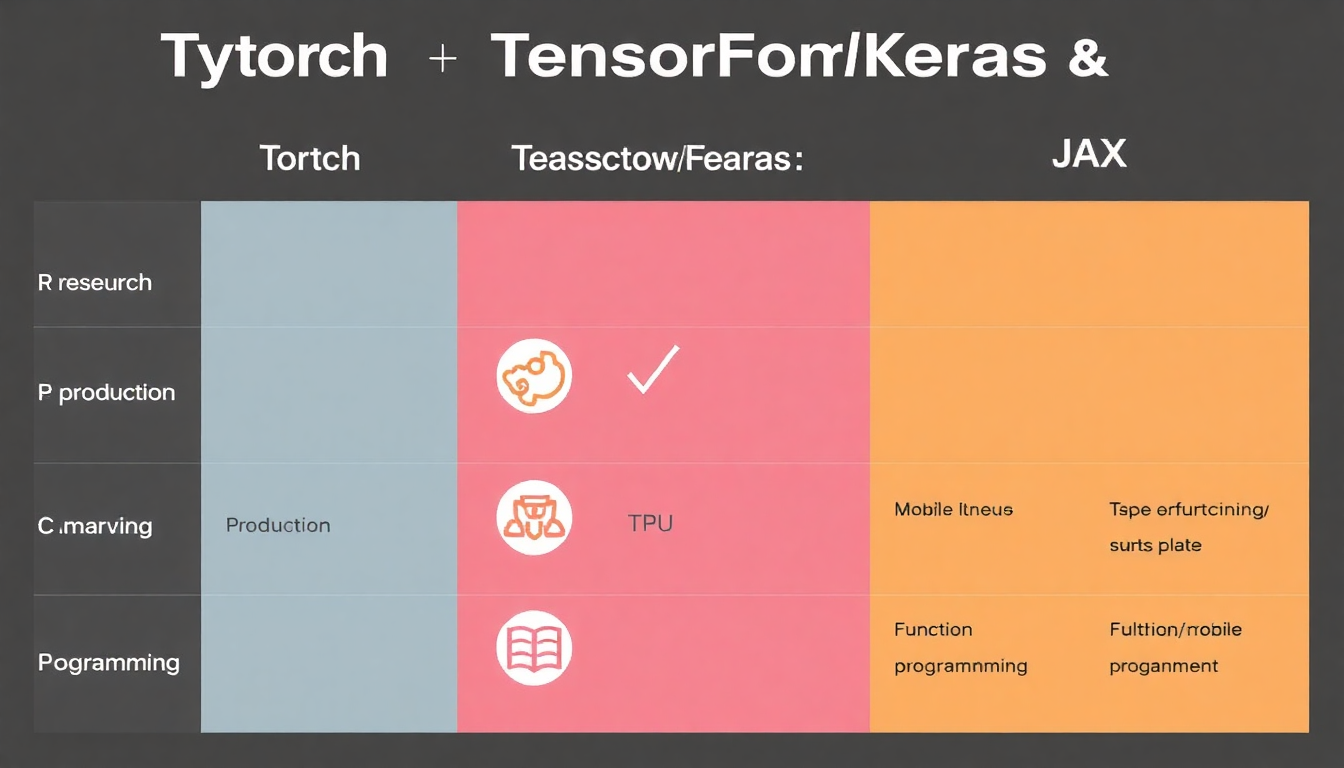

어떤 파이썬 딥러닝 프레임워크를 선택할지는 프로젝트의 목적과 팀의 경험에 따라 달라질 수 있습니다. 다음 표를 통해 각 프레임워크의 특징을 한눈에 비교해보고, 여러분의 프로젝트에 가장 적합한 프레임워크를 선택하는 데 도움을 받아보세요.

| 특징 | PyTorch | TensorFlow / Keras | JAX |

|---|---|---|---|

| 주요 용도 | 연구 개발, 커스텀 모델, 빠른 프로토타이핑 | 대규모 프로덕션 시스템, 모바일/엣지 배포, 분산 학습 | 최첨단 연구, 고성능 컴퓨팅, 함수형 프로그래밍 |

| 학습 곡선 | 파이썬ic하여 비교적 낮음 | Keras는 낮음, TensorFlow 저수준은 높음 | NumPy 유사하나 함수형 개념 필요 |

| 분산/TPU/엣지 | 좋은 지원 (Torch Distributed) | 매우 강력한 지원 (TPU, TFLite, TF Serving) | XLA 컴파일러로 GPU/TPU 가속 극대화 |

| 생태계 | 활발한 연구 커뮤니티, Hugging Face 등 | 거대한 기업 지원, MLflow, TFX 등 MLOps 도구 | 빠르게 성장 중, 아직은 상대적으로 작음 |

사용 목적별로 살펴보면, 만약 새로운 아이디어를 빠르게 실험하고 논문 구현 같은 연구 개발에 집중한다면 PyTorch를 기본으로 추천합니다. 이때 고성능 수치 계산이 필요한 경우 JAX를 고려할 수 있습니다. 반면, 대규모 온라인 서비스나 모바일 앱, 혹은 엣지 디바이스에 AI 모델을 배포해야 한다면 TensorFlow와 그 생태계(TensorFlow Lite, TensorFlow Serving)가 제공하는 강력한 도구들이 큰 도움이 될 것입니다. 특히 최첨단 연구를 수행하며 TPU 같은 고성능 컴퓨팅 리소스를 적극적으로 활용하고자 한다면, JAX가 매우 유리한 선택이 될 수 있습니다.

파이썬 딥러닝 프레임워크의 신뢰성과 현재 트렌드를 살펴보면, 2024년 기준 GitHub 스타 수나 논문 코드 저장소에서의 채택률 등 여러 지표에서 PyTorch와 TensorFlow가 선두를 다투고 있으며, JAX 역시 연구 커뮤니티 내에서 빠르게 영향력을 확대하고 있습니다. 많은 글로벌 기업들이 PyTorch와 TensorFlow를 사용하여 다양한 AI 서비스를 구축하고 있으며, 이러한 활발한 커뮤니티와 기업 활용 사례는 각 프레임워크의 견고함을 보여줍니다.

2-3. 실무 활용 팁

AI 개발 실무에서는 단순히 모델을 만드는 것을 넘어, 모델의 성능을 최적화하고 유연하게 배포하는 전략이 중요합니다.

-

하이브리드 접근 전략: 특정 파이썬 딥러닝 프레임워크에 모델이 종속되지 않도록 하는 유연한 배포 전략이 필요합니다. 예를 들어, PyTorch로 개발된 모델을 ONNX(Open Neural Network Exchange)와 같은 표준 형식으로 변환하여 TensorRT나 OpenVINO 같은 다양한 런타임 환경에서 배포하는 방식입니다. 이는 모델을 개발한 환경과 관계없이 여러 장치에서 효율적으로 실행할 수 있게 해줍니다.

-

GPU/TPU 최적화 기법: 모델 학습 성능을 극대화하기 위해서는 하드웨어 자원을 효율적으로 사용해야 합니다. AMP(Automatic Mixed Precision, 자동 혼합 정밀도)를 사용하여 연산 속도를 높이고 메모리 사용량을 줄이거나, DataLoader 최적화를 통해 데이터 로딩 병목 현상을 해결하는 것이 중요합니다. 또한, 적절한 배치 사이즈(Batch Size)를 튜닝하는 것도 학습 속도와 모델 성능에 큰 영향을 미칩니다.

-

모델 경량화 기술: 실제 서비스 환경에서는 모델의 크기가 작고 빠르게 동작해야 합니다.

-

양자화(Quantization): 모델의 가중치를 더 낮은 정밀도로 바꿔 메모리 사용량을 줄이고 연산 속도를 높이는 기법입니다. 예를 들어 32비트 부동소수점 숫자를 8비트 정수로 바꾸는 방식입니다.

-

가지치기(Pruning): 모델에서 중요도가 낮은 연결이나 뉴런을 제거하여 모델 크기를 줄이고 불필요한 연산을 없애는 기법입니다.

-

지식 증류(Distillation): 크고 복잡한 ‘선생님 모델’의 지식을 작고 효율적인 ‘학생 모델’에 가르쳐, 성능은 유지하면서 모델 크기를 줄이는 기법입니다.

-

3. Python FastAPI 활용법: AI 서비스 구축의 새로운 표준

AI 모델을 개발하는 것만큼 중요한 것은 이 모델을 실제 사용자들이 쓸 수 있는 서비스로 만드는 것입니다. 이때 Python FastAPI 활용법은 빠르고 효율적인 AI 서비스 구축의 새로운 표준으로 떠오르고 있습니다.

3-1. FastAPI가 AI 개발에 최적인 이유

FastAPI는 현대적인 파이썬 웹 프레임워크로, AI 모델 서빙(Serving)에 특히 강력한 장점을 가지고 있습니다.

-

핵심 장점 요약:

-

고성능 비동기 처리: ASGI(Asynchronous Server Gateway Interface) 기반으로 비동기 처리를 지원하여, Flask 같은 다른 프레임워크보다 훨씬 빠른 웹 API를 구축할 수 있습니다. 이는 특히 여러 AI 추론 요청을 동시에 처리해야 하는 ML 추론 서버에 매우 적합하며, Flask 대비 5~10배 빠른 속도를 제공할 수 있습니다.

-

강력한 데이터 유효성 검사 및 자동 문서화: 파이썬의 타입 힌트(Type Hint)를 활용하여 입력 데이터의 유효성을 자동으로 검사합니다. 또한, OpenAPI 표준(Swagger UI, ReDoc 등)을 기반으로 API 문서를 자동으로 생성해주어 개발 생산성을 크게 높여줍니다. 개발자는 문서 작성에 드는 시간을 절약하고 핵심 개발에 집중할 수 있습니다.

-

현대적인 스택: Starlette(가벼운 ASGI 웹 프레임워크)와 Pydantic(데이터 유효성 검사 라이브러리) 위에 구축되어 있어, 파이썬의 최신 비동기 기능을 최대한 활용합니다.

-

기존 파이썬 웹 프레임워크와 비교해 볼까요? Flask는 가볍고 시작하기 쉽지만, 비동기 처리나 대규모 서비스 구축 시 개발자가 직접 구현해야 하는 부분이 많습니다. Django나 Django REST Framework(DRF)는 풍부한 생태계와 강력한 ORM(객체 관계 매핑)을 제공하지만, 상대적으로 무겁고 초기 설정이 복잡할 수 있습니다. 이와 비교하여 Python FastAPI 활용법은 가볍고 빠르면서도, 특히 ML 모델 서빙에 특화된 현대적인 선택지라고 할 수 있습니다. 높은 성능과 개발 편의성을 동시에 제공하여 AI 서비스 개발에 최적화되어 있습니다.

3-2. FastAPI로 딥러닝 모델 서빙하기 (실무 예제)

실제로 FastAPI를 이용해 딥러닝 모델을 웹 서비스로 만드는 과정을 살펴보겠습니다.

기본 구조 설정

먼저 프로젝트 디렉토리 구조는 다음과 같이 설정할 수 있습니다.

.

├── main.py

├── models/

│ └── trained_model.pt (예시: 학습된 PyTorch 모델)

└── schemas/

└── input_schema.py

main.py는 FastAPI 애플리케이션의 핵심이 되고, models/ 폴더에는 학습된 딥러닝 모델을, schemas/ 폴더에는 Pydantic을 활용한 입력/출력 데이터 형식을 정의합니다.

딥러닝 모델 통합 코드 예시 및 설명

모델을 로드하는 것은 비용이 많이 드는 작업이므로, 애플리케이션 시작 시점에 한 번만 로드하여 메모리 효율성을 높이고 초기 요청 응답 시간을 단축하는 것이 중요합니다. FastAPI는 @app.on_event("startup") 데코레이터를 통해 이 작업을 처리할 수 있습니다.

from fastapi import FastAPI, HTTPException

from pydantic import BaseModel

import torch # 예시: PyTorch 모델 로딩 (실제 모델 객체를 의미)

app = FastAPI()

model = None # 모델 객체를 전역 변수로 관리

# 입력 데이터의 형태를 정의하는 Pydantic 모델

class ItemInput(BaseModel):

data: list[float] # 실수형 숫자의 리스트를 입력으로 받음

# 애플리케이션 시작 시 모델 로드 및 초기화

@app.on_event("startup")

def load_model():

"""애플리케이션 시작 시 모델 로드 및 초기화"""

global model

try:

# 실제 모델 로딩 로직 (예: torch.jit.load("models/trained_model.pt"))

# 여기서는 학습된 딥러닝 모델 객체를 로드하는 것으로 가정합니다.

# GPU 사용을 원한다면 .to('cuda')를 추가할 수 있습니다.

model = "Loaded_DeepLearning_Model_Object"

print("Model loaded successfully!")

except Exception as e:

print(f"Failed to load model: {e}")

# 모델 로드 실패 시 애플리케이션이 시작되지 않도록 처리할 수 있습니다.

# 또는 모델 로드가 필수적이지 않은 경우, 이 에러를 기록하고 계속 진행할 수 있습니다.

# 모델 추론 엔드포인트 구현

@app.post("/predict")

async def predict_item(item: ItemInput):

"""모델 추론 엔드포인트"""

if model is None:

raise HTTPException(status_code=500, detail="Model not loaded yet.")

# 실제 모델 추론 로직을 여기에 구현합니다.

# 예: with torch.no_grad(): output = model(torch.tensor(item.data).to('cuda'))

# 여기서는 입력 데이터의 평균을 더미 결과로 반환합니다.

if not item.data:

prediction = 0.0

else:

prediction = sum(item.data) / len(item.data)

return {"prediction": prediction}

# 실행 방법: 터미널에서 `uvicorn main:app --reload`

위 코드 예시에서 async def를 사용하여 비동기 엔드포인트를 만들고, Pydantic의 BaseModel을 상속받아 입력 데이터의 유효성을 검증합니다. @app.on_event("startup")을 통해 모델을 한 번만 로드하여 효율성을 높였습니다. 실제 모델 추론 로직은 predict_item 함수 안에 구현하며, 필요에 따라 model.to('cuda')와 같이 GPU를 활용할 수 있습니다.

3-3. 성능 최적화 전략 및 실무 배포 사례

FastAPI로 AI 서비스를 배포할 때는 성능 최적화와 안정적인 운영이 중요합니다.

-

성능 최적화 전략:

-

비동기 처리 패턴:

async/await키워드를 활용하여 I/O 바운드 작업(예: 데이터베이스 접근, 외부 API 호출)을 비동기적으로 처리하면, 애플리케이션이 다른 요청을 동시에 처리할 수 있어 효율성이 크게 높아집니다. -

배치 추론(Batch Inference): 여러 사용자의 요청을 모아서 한 번에 모델 추론을 수행하면 GPU 활용률을 극대화하고 전체 처리량을 늘릴 수 있습니다.

-

큐 기반 비동기 작업: Redis Queue(RQ)나 Celery와 같은 메시지 큐를 활용하여 장시간이 소요되는 복잡한 AI 작업을 비동기적으로 처리하면, 웹 서버의 응답성을 유지하면서도 대규모 작업을 효율적으로 처리할 수 있습니다.

-

모델 캐싱 및 메모리 관리: 모델 가중치를 메모리에 상주시켜 매번 다시 로드하는 오버헤드를 줄이고, 불필요한 객체는 즉시 해제하여 메모리 효율성을 높이는 것이 중요합니다.

-

멀티워커 배포: Gunicorn과 Uvicorn을 조합하여 여러 워커 프로세스를 통해 FastAPI 애플리케이션을 실행하면, 동시에 처리할 수 있는 요청 수를 늘려 서비스의 처리량을 크게 향상시킬 수 있습니다.

-

-

실무 배포 사례:

-

Docker 컨테이너화: FastAPI 애플리케이션과 모든 의존성을 Docker 이미지로 빌드하면, 어떤 환경에서든 동일하게 실행되는 ‘컨테이너’를 만들 수 있어 이식성과 배포 용이성을 확보합니다.

-

Kubernetes 오케스트레이션: Docker 컨테이너를 Kubernetes 클러스터에 배포하면, 수많은 컨테이너를 효율적으로 관리하고, 트래픽에 따라 자동으로 서버 자원을 늘리거나 줄이는 ‘오토스케일링’, 요청을 여러 서버로 나누어 분산시키는 ‘로드 밸런싱’ 등을 통해 안정적인 서비스를 운영할 수 있습니다.

-

모니터링 및 로깅: Prometheus와 Grafana를 활용하여 서비스의 CPU, 메모리 사용량, 요청 수 같은 핵심 지표를 실시간으로 모니터링하고, ELK Stack(Elasticsearch, Logstash, Kibana) 또는 클라우드 제공 로그 서비스를 활용하여 로그를 수집 및 분석함으로써 문제 발생 시 빠르게 대처할 수 있습니다.

-

실제 기업 사례: Python FastAPI 활용법은 제조 분야의 품질 예측 솔루션, 금융권의 실시간 이상 거래 탐지, 또는 이미지/텍스트 분석 API 등 다양한 산업 분야에서 고성능 AI 서비스의 핵심 구성 요소로 활발히 사용되고 있습니다.

-

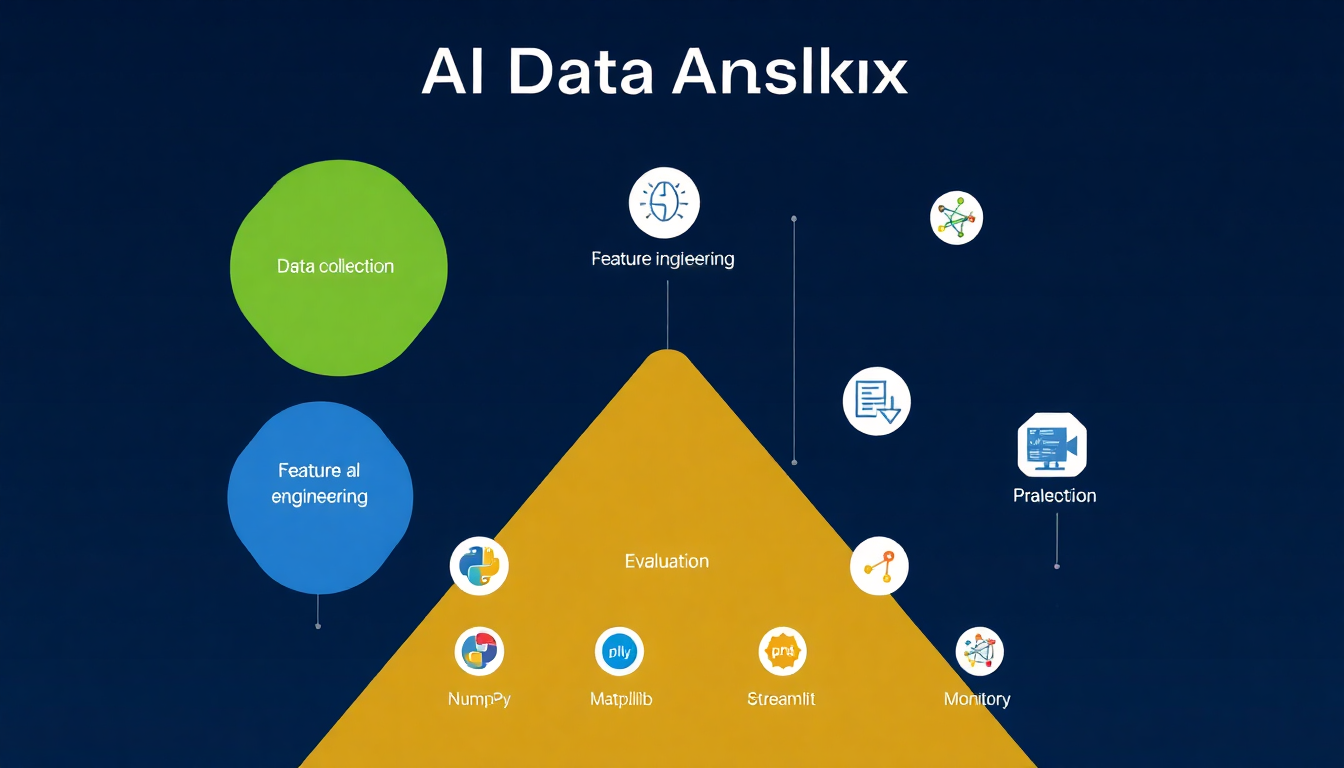

4. AI 데이터 분석 사례: 실전 프로젝트로 배우기

AI 개발에 있어 모델만큼이나 중요한 것이 바로 데이터를 이해하고 처리하는 능력입니다. 실제 AI 데이터 분석 사례를 통해 데이터의 중요성을 이해하고 실무 워크플로우를 익혀보겠습니다.

4-1. 데이터 분석 필수 라이브러리

AI 데이터 분석을 위한 파이썬 라이브러리들은 데이터 처리부터 시각화, 그리고 웹 대시보드 구축에 이르기까지 광범위하게 활용됩니다.

-

데이터 처리:

-

Pandas: 파이썬 데이터 분석의 사실상 표준 라이브러리입니다. ‘데이터프레임’이라는 강력한 구조를 통해 엑셀 시트처럼 정형 데이터를 쉽고 효율적으로 처리하고 분석할 수 있습니다.

-

Polars: Rust 언어 기반의 고성능 데이터프레임 라이브러리로, 대용량 데이터를 처리할 때 Pandas보다 10배 이상 빠른 성능을 제공하여 차세대 데이터 처리 라이브러리로 주목받고 있습니다. 복잡한 연산에서도 빠른 속도를 자랑합니다.

-

NumPy: 파이썬의 과학 계산 핵심 라이브러리입니다. 다차원 배열 객체와 함께 선형 대수와 같은 고성능 수치 계산 기능을 제공하여, 딥러닝 모델의 기본 연산부터 데이터 전처리까지 폭넓게 사용됩니다.

-

-

시각화:

-

Matplotlib, Seaborn: 데이터 시각화의 기본 라이브러리입니다. 다양한 종류의 정적 그래프(꺾은선 그래프, 막대 그래프, 산점도 등)를 그릴 수 있으며, Seaborn은 Matplotlib을 기반으로 더 아름답고 통계적인 그래프를 쉽게 만들 수 있게 돕습니다.

-

Plotly: 인터랙티브한 시각화를 만들고 대시보드를 구축하는 데 강점을 가집니다. 마우스로 확대/축소하거나 데이터를 선택하는 등의 동적인 기능을 제공하여 데이터 탐색에 매우 유용합니다.

-

-

빠른 대시보드/데모 구축:

-

Streamlit: 데이터 과학자나 ML 개발자가 코드를 몇 줄 작성하는 것만으로도 아름다운 웹 앱이나 대시보드를 빠르게 만들 수 있게 해주는 라이브러리입니다. 복잡한 웹 개발 지식 없이도 아이디어를 시각화하고 공유할 수 있습니다.

-

4-2. 실제 AI 데이터 분석 사례 (2024년 기준)

실제 산업 현장에서 AI 데이터 분석 사례가 어떻게 활용되고 있는지 구체적인 예시를 통해 알아보겠습니다.

사례 1: 교통 데이터 예측 시스템

-

프로젝트 개요: 도심의 실시간 교통 데이터(차량 속도, 통행량), 날씨 정보, 그리고 축제나 행사 같은 이벤트 데이터를 모두 모아 분석합니다. 이를 통해 미래의 교통 상황(예: 1시간 후 특정 도로의 정체 수준)을 예측하는 시스템을 구축하는 프로젝트입니다. 이 예측 시스템은 하루에 4회 이상 전국 교통 데이터를 업데이트하며 최신 정보를 반영합니다.

-

사용 기술 스택: 주로 Python을 기반으로 Pandas(대용량 데이터의 경우 Polars)를 사용하여 다양한 교통 데이터를 처리합니다. 예측 모델은 파이썬 딥러닝 프레임워크(예: PyTorch)를 활용하여 시계열 예측 모델(시간의 흐름에 따른 변화를 예측하는 모델)을 개발합니다.

-

결과 및 비즈니스 임팩트: 예측 정확도가 높아지면서 교통 체증을 미리 알려주고 우회 도로를 안내하여 시민들의 이동 시간을 줄일 수 있습니다. 물류 회사들은 최적의 경로를 선택해 배송 비용을 절감하며, 도시 계획가들은 예측 데이터를 기반으로 효율적인 도로 건설이나 대중교통 노선 개선 계획을 세울 수 있습니다. 한 연구에 따르면, AI 기반 교통 예측 시스템은 도시의 평균 통행 시간을 최대 15% 단축할 수 있는 잠재력을 가지고 있습니다.

사례 2: 제조업 품질 예측 솔루션

-

프로젝트 개요: 제조 공장에서 발생하는 수많은 센서 데이터(예: 생산 라인의 온도, 압력, 기계 진동 등)를 실시간으로 수집하고 분석합니다. 이 데이터를 통해 제품의 불량 발생을 미리 예측하고, 기계의 이상 징후를 탐지하는 솔루션입니다.

-

사용 기술 스택: 센서 데이터를 처리하기 위해 Pandas를 사용하고, 이상 탐지 모델은 파이썬 딥러닝 프레임워크(예: TensorFlow)를 기반으로 구축됩니다. 이렇게 학습된 모델은 Python FastAPI 활용법을 통해 웹 서비스 형태로 배포되며, Plotly나 Streamlit으로 만든 실시간 모니터링 대시보드를 통해 현장 관리자들이 불량률이나 기계 상태를 한눈에 확인할 수 있습니다.

-

결과 및 비즈니스 임팩트: 불량품이 발생하기 전에 미리 예측하여 생산 공정을 조정함으로써 불량률을 크게 낮출 수 있습니다. 이는 생산성 향상으로 직결되며, 갑작스러운 기계 고장으로 인한 생산 중단을 줄여 예측 기반 유지보수를 가능하게 하여 비용을 절감합니다. 특정 공장에서는 이 솔루션 도입 후 불량률이 20% 감소하고, 예기치 않은 장비 고장이 30% 줄어들었다는 보고도 있습니다.

사례 3: 금융/마케팅 데이터 분석

-

프로젝트 개요: 고객의 행동 데이터(웹사이트 방문 기록, 앱 사용 패턴), 거래 기록, 인구 통계학적 정보 등을 종합적으로 분석하여 고객을 여러 그룹으로 나누고(고객 세분화), 어떤 고객이 서비스를 떠날지 예측(이탈 예측)하며, 각 고객에게 가장 적합한 상품을 추천하는 프로젝트입니다.

-

사용 기술 스택: Scikit-learn이나 XGBoost 같은 전통적인 머신러닝 알고리즘이 주로 사용되며, Pandas를 활용한 정교한 데이터 전처리 과정이 필수적입니다.

-

결과 및 비즈니스 임팩트: 정확한 고객 타겟팅을 통해 마케팅 캠페인의 효율을 높이고, 고객 이탈을 미리 예측하여 선제적인 대응으로 고객을 유지함으로써 수익을 증대시킬 수 있습니다. 또한, A/B 테스트를 통해 새로운 모델이나 전략이 실제로 고객 행동에 어떤 긍정적인 영향을 미 미치는지 정량적으로 비교할 수 있습니다.

4-3. 데이터 분석 프로젝트 워크플로우

성공적인 AI 데이터 분석 사례 프로젝트는 체계적인 워크플로우를 따릅니다.

-

문제 정의 및 데이터 수집: 무엇을 해결하고 싶은지 명확히 하고, 필요한 데이터를 수집합니다.

-

탐색적 데이터 분석(EDA): Pandas와 Seaborn을 활용하여 데이터를 자세히 살펴보고 숨겨진 패턴이나 문제점을 찾아냅니다.

-

특성 엔지니어링(Feature Engineering): 원본 데이터에서 모델 학습에 더 유용한 새로운 특징(feature)을 만들어냅니다.

-

모델 선택 및 학습: Scikit-learn이나 파이썬 딥러닝 프레임워크를 사용하여 데이터에 가장 적합한 모델을 선택하고 학습시킵니다.

-

모델 평가 및 검증: 학습된 모델이 얼마나 정확하고 신뢰할 수 있는지 다양한 지표로 평가하고 검증합니다.

-

모델 배포: Python FastAPI 활용법을 통해 학습된 모델을 실제 사용 가능한 서비스로 만듭니다.

-

모니터링 및 재학습: 배포된 모델의 성능을 지속적으로 모니터링하고, 필요에 따라 데이터를 업데이트하여 모델을 다시 학습(재학습)시킵니다. MLflow와 같은 MLOps 도구가 이 과정에 활용됩니다.

5. 통합 개발 환경 구축: AI 실무자의 필수 도구

AI 개발 실무에서는 효율적인 개발을 위한 잘 갖춰진 환경이 필수입니다. 여기서는 AI 실무자가 반드시 알아야 할 개발 환경 설정부터 협업 도구, 그리고 MLOps와 클라우드 플랫폼 활용법까지를 다룹니다.

5-1. 개발 환경 설정

-

IDE 선택: 여러분의 작업 스타일에 맞는 통합 개발 환경(IDE)을 선택하는 것이 중요합니다.

-

PyCharm: 파이썬 개발에 특화된 강력한 기능을 제공하며, 전문적인 AI 프로젝트 개발에 적합합니다. 코드 자동 완성, 디버깅, 가상환경 관리 등 뛰어난 개발 경험을 제공합니다.

-

VS Code: 가볍고 범용적인 에디터이지만, 다양한 확장 기능을 통해 파이썬 개발에 필요한 모든 기능을 갖출 수 있습니다. 유연성과 확장성이 높아 많은 개발자에게 사랑받고 있습니다.

-

Jupyter Notebook/Lab: 탐색적 데이터 분석(EDA)이나 빠른 프로토타이핑에 매우 유용합니다. 코드를 블록 단위로 실행하며 결과를 즉시 확인할 수 있어 데이터 과학자들에게 필수적인 도구입니다. 이 세 가지 도구를 프로젝트 단계에 따라 병행하여 사용하는 것을 권장합니다.

-

-

가상환경 관리: 파이썬 프로젝트마다 다른 라이브러리 버전이 필요할 수 있으므로, ‘가상환경’을 사용하여 프로젝트별로 독립적인 파이썬 환경을 구축하는 것이 중요합니다. Conda, venv, Poetry와 같은 도구들이 있으며, 이들은 프로젝트의 의존성(필요한 라이브러리)을 체계적으로 관리하고 다른 프로젝트와의 충돌을 막아줍니다.

5-2. 버전 관리 및 협업

AI 프로젝트는 혼자서 하는 경우가 드물며, 팀원들과의 협업이 필수적입니다.

-

Git/GitHub: 코드의 변경 이력을 관리하고 여러 명이 함께 작업할 수 있도록 돕는 ‘버전 관리 시스템’의 사실상 표준입니다. Git을 사용하여 코드를 버전별로 저장하고, GitHub와 같은 원격 저장소를 통해 팀원들과 코드를 공유하며 협업합니다. ‘브랜치 전략'(예: 기능 개발용

feature브랜치, 안정적인develop브랜치, 배포용main브랜치)을 활용하고, ‘Pull Request(PR)’와 ‘코드 리뷰’ 문화를 통해 코드 품질을 높이고 팀원 간 지식을 공유하는 것이 중요합니다.

5-3. MLOps 도구 통합

MLOps(Machine Learning Operations)는 AI 모델 개발부터 배포, 운영까지의 모든 과정을 자동화하고 효율화하는 방법론입니다.

-

실험 관리: MLflow, Weights & Biases(W&B)와 같은 도구들은 모델 학습 과정에서 사용된 파라미터(설정값), 학습 결과, 모델 파일 등을 체계적으로 기록하고 관리할 수 있도록 돕습니다. 이는 수많은 실험을 진행하는 AI 개발 과정에서 어떤 실험이 가장 좋은 성능을 냈는지 추적하고 재현하는 데 필수적입니다.

-

모델 버전 관리(Model Registry): 학습이 완료된 모델도 소프트웨어처럼 버전 관리가 필요합니다. 모델 레지스트리는 학습된 모델의 버전을 관리하고, 특정 버전의 모델을 쉽게 배포하거나 롤백(이전 버전으로 되돌리는 것)할 수 있게 해줍니다.

-

CI/CD 파이프라인: CI/CD(Continuous Integration/Continuous Deployment) 파이프라인은 모델 학습, 테스트, 배포 과정을 자동화하여 개발 주기를 단축하고 안정성을 높입니다. 코드가 변경될 때마다 자동으로 테스트를 실행하고, 문제가 없으면 배포까지 진행함으로써 휴먼 에러를 줄이고 빠르게 서비스를 업데이트할 수 있습니다.

5-4. 클라우드 플랫폼 활용

대규모 AI 프로젝트나 고성능 컴퓨팅 자원이 필요할 때는 클라우드 플랫폼을 활용합니다.

-

주요 클라우드 AI/ML 서비스: AWS SageMaker, Google Cloud Platform Vertex AI, Azure Machine Learning과 같은 서비스들은 AI 모델 개발부터 배포, MLOps까지 전체 워크플로우를 지원하는 통합 플랫폼을 제공합니다.

-

GPU 인스턴스 선택 가이드: AI 모델 학습에 필수적인 GPU 인스턴스는 프로젝트의 요구사항(필요한 연산량, 메모리 크기, 예산)에 따라 신중하게 선택해야 합니다. 예를 들어, NVIDIA Tesla V100은 범용적인 고성능 학습에, A100은 최신 대규모 모델 학습에 적합합니다. 작은 규모의 실험에는 T4 같은 인스턴스도 좋은 선택입니다.

-

비용 최적화 전략: 클라우드 리소스 사용 시 비용 효율성을 높이는 것이 중요합니다. 사용량이 적은 시간대에는 인스턴스를 종료하거나, 스팟 인스턴스(Spot Instance)를 활용하여 저렴하게 GPU 자원을 이용할 수 있습니다. 또한, 장기적으로 사용할 리소스는 예약 인스턴스(Reserved Instance)를 통해 할인받는 방법도 있습니다.

6. 2025년 AI 개발 트렌드와 학습 로드맵

AI 기술은 끊임없이 진화하고 있으며, 2025년에도 새로운 트렌드가 AI 개발자들의 역량을 요구할 것입니다. 이러한 변화에 발맞춰 지속적으로 학습하고 성장하는 것이 중요합니다.

6-1. 주목해야 할 기술 트렌드

-

LLM 및 생성형 AI 활용 확대: 챗봇, 이미지 생성, 코드 작성 등 다양한 분야에서 거대 언어 모델(LLM)과 확산 모델(Diffusion Model)을 포함한 생성형 AI의 활용이 더욱 확대될 것입니다. 이 분야에서는 파이썬 딥러닝 프레임워크를 통해 새로운 모델을 연구하고, Python FastAPI 활용법으로 이를 실제 서비스로 빠르게 전환하는 것이 중요해집니다.

-

온디바이스 AI (모바일/엣지): 스마트폰, IoT 기기, 자동차 등 네트워크 연결 없이 기기 자체에서 AI 모델이 직접 추론을 수행하는 온디바이스 AI의 중요성이 커지고 있습니다. 이를 위해서는 모델 경량화 기술이 필수적이며, 파이썬 딥러닝 프레임워크로 경량화된 모델을 만들고, 효율적인 배포 전략(MLOps)을 수립하는 것이 핵심입니다.

-

AI 에이전트 및 AutoML: 스스로 목표를 설정하고 계획을 세워 작업을 수행하는 AI 에이전트와, 머신러닝 모델 개발 과정을 자동으로 처리하는 AutoML 기술의 발전도 주목해야 합니다. 이러한 자동화된 시스템에서도 파이썬 딥러닝 프레임워크는 핵심적인 역할을 하며, Python FastAPI 활용법은 이러한 에이전트나 AutoML 시스템의 구성 요소를 서비스화하는 데 기여합니다.

-

MLOps 및 AI 플랫폼 고도화: AI 모델의 신뢰성, 확장성, 지속적인 개선을 위한 MLOps는 더욱 중요해질 것입니다. 파이썬 딥러닝 프레임워크로 개발된 모델을 Python FastAPI 활용법으로 효율적으로 배포하고, 모니터링하며 재학습하는 전체 과정을 자동화하는 MLOps 파이프라인 구축 역량이 중요해집니다.

6-2. 단계별 학습 로드맵

AI 개발자로 성장하기 위한 단계별 학습 로드맵을 제시합니다.

| 단계 | 학습 내용 |

|---|---|

| 입문자 (1-3개월) | – Python 기초 문법 마스터: 변수, 자료형, 조건문, 반복문, 함수, 클래스 등 – 핵심 데이터 처리 라이브러리 숙달: NumPy(수치 계산), Pandas(데이터프레임) – 기본 머신러닝 알고리즘 이해: Scikit-learn을 활용하여 회귀, 분류, 클러스터링 등 기본 모델 학습 및 평가 |

| 중급자 (3-6개월) | – 파이썬 딥러닝 프레임워크 선택 및 심화 학습: PyTorch 또는 TensorFlow 중 하나를 선택하여 심층적으로 학습 – 주요 딥러닝 아키텍처 이해: CNN(이미지), RNN(시퀀스), Transformer(자연어) 등 핵심 아키텍처 원리 및 구현 – Python FastAPI 활용법 학습: 간단한 AI 모델을 웹 API로 서빙하고 배포하는 경험 구축 |

| 실무자 (6개월 이상) | – MLOps 및 프로덕션 환경 배포 기술 심화: Docker, Kubernetes, 클라우드 ML 플랫폼(AWS SageMaker, GCP Vertex AI 등)을 활용한 모델 배포 및 관리 – 다양한 AI 데이터 분석 사례를 기반으로 실전 포트폴리오 구축: 실제 문제 해결을 위한 데이터 분석 및 모델 개발 경험 축적 – 대규모 AI 프로젝트 참여 및 기여: 실제 서비스에 적용되는 AI 시스템 개발 및 운영 경험 쌓기 |

6-3. 추천 학습 리소스

-

공식 문서 및 튜토리얼: 각 파이썬 딥러닝 프레임워크(PyTorch, TensorFlow, JAX)와 FastAPI의 공식 문서 및 튜토리얼은 가장 정확하고 최신 정보를 제공합니다.

-

온라인 강의 플랫폼: Coursera, fast.ai, Udacity, Inflearn(인프런) 등에서 제공하는 전문 강의를 통해 체계적인 지식을 습득할 수 있습니다.

-

Kaggle과 같은 실전 경험 플랫폼: Kaggle 같은 데이터 과학 경진대회에 참여하여 실제 데이터를 다루고 모델을 개발하는 실전 경험을 쌓을 수 있습니다.

-

오픈소스 프로젝트 기여: GitHub 등에서 진행되는 오픈소스 프로젝트에 참여하여 실제 코드를 다루고 기여하면서 실력을 향상시키고, 다른 개발자들과 교류할 수 있습니다.

7. 결론: 실무 중심 학습의 중요성

AI 기술은 멈추지 않고 발전하며, 이 분야에서 성공하기 위해서는 이론 학습과 함께 실제 문제 해결 능력을 키우는 것이 매우 중요합니다. 이 글에서 다룬 핵심 내용을 다시 한번 강조하며, 여러분의 AI 개발 여정에 도움이 될 실무 적용 액션 플랜을 제시합니다.

7-1. 핵심 요약

-

파이썬 딥러닝 프레임워크: PyTorch와 TensorFlow를 중심으로 프로젝트의 목적(연구 또는 프로덕션)에 맞는 현명한 프레임워크 선택이 성공적인 AI 개발의 첫걸음입니다. JAX는 고성능 연구 분야에서 새로운 가능성을 제시합니다.

-

Python FastAPI 활용법: 빠르고 효율적인 AI 서비스 구축의 핵심 도구로서 FastAPI는 비동기 처리와 자동 문서화 기능을 통해 개발 생산성과 서비스 안정성을 크게 높여줍니다. 이는 현대적인 AI 모델 배포 전략에서 필수적인 요소입니다.

-

AI 데이터 분석 사례: 실제 AI 데이터 분석 사례를 통해 문제 정의부터 데이터 처리, 모델링, 배포에 이르는 전 과정에 대한 실질적인 경험을 쌓는 것이 AI 개발 실무 역량 강화의 핵심입니다. 이론적 지식만으로는 부족하며, 다양한 사례를 통해 배운 것을 직접 적용해보는 것이 중요합니다.

7-2. 실무 적용을 위한 액션 플랜

AI 개발 실력을 빠르게 향상시키기 위한 구체적인 액션 플랜을 제안합니다.

-

작은 프로젝트부터 시작: 관심 있는 작은 아이디어를 하나 선택하여, 파이썬 딥러닝 프레임워크로 모델을 만들고, Python FastAPI 활용법으로 간단한 API를 구축하며, 최소한의 MLOps 개념을 적용하여 실제 서비스까지 구현해보는 경험을 쌓으세요. 처음부터 완벽할 필요는 없습니다.

-

GitHub에 코드 공개 및 커뮤니티 기여: 개발한 코드와 프로젝트를 GitHub에 공개하고, Kaggle과 같은 플랫폼의 경진대회에 참여하거나 오픈소스 프로젝트에 기여하면서 다른 개발자들과 교류하세요. 이는 여러분의 실력을 검증받고, 더 넓은 네트워킹 기회를 확보하는 데 큰 도움이 됩니다.

7-3. 마무리 메시지

AI 개발자로 성장하기 위해서는 이론 학습과 실무 경험의 균형이 무엇보다 중요합니다. 끊임없이 배우고, 새로운 기술 트렌드를 파악하며, 여러분의 아이디어를 실제 세상에 구현하기 위해 지속적으로 도전해야 합니다. 이 글이 여러분의 AI 개발 여정에서 다음 단계로 나아갈 수 있는 구체적인 동기와 실질적인 가이드가 되기를 바랍니다. 오늘 배운 지식을 바탕으로 여러분만의 멋진 AI 프로젝트를 시작해 보세요!

자주 묻는 질문 (FAQ)

Q: 파이썬 딥러닝 프레임워크 중 어떤 것을 선택해야 하나요?

A: 프로젝트의 목적에 따라 다릅니다. 연구 개발이나 빠른 프로토타이핑에는 PyTorch가 유용하며, 대규모 프로덕션 환경이나 모바일/엣지 배포에는 TensorFlow/Keras가 강력합니다. 최첨단 연구와 고성능 컴퓨팅에는 JAX를 고려할 수 있습니다.

Q: FastAPI가 AI 서비스 구축에 왜 최적인가요?

A: FastAPI는 고성능 비동기 처리, 강력한 데이터 유효성 검사, 그리고 OpenAPI 표준을 기반으로 한 자동 문서화 기능을 제공하여 AI 모델 서빙에 매우 효율적이고 개발 생산성을 높여주기 때문입니다.

Q: AI 모델 경량화 기술에는 어떤 것들이 있나요?

A: 주로 양자화(Quantization), 가지치기(Pruning), 지식 증류(Distillation) 기술이 사용됩니다. 이들은 모델의 크기를 줄이고 연산 속도를 높여 실제 서비스 환경에서의 효율성을 극대화합니다.

Q: MLOps란 무엇이며, 왜 중요한가요?

A: MLOps는 AI 모델 개발부터 배포, 운영까지의 모든 과정을 자동화하고 효율화하는 방법론입니다. AI 모델의 신뢰성, 확장성, 지속적인 개선을 보장하고, 개발 주기를 단축하여 빠르게 서비스를 업데이트하는 데 필수적입니다.